Estudio de EE.UU. expone vulnerabilidades de seguridad en la IA china DeepSeek

¿Por qué los modelos estadounidenses la superan en benchmarks y resistencia a jailbreaks? ¿Tiene bias el análisis hecho por CAISI?

La inteligencia artificial china DeepSeek ha recibido duras críticas tras un estudio realizado por el Centro para Estándares e Innovación en IA (CAISI) del Instituto Nacional de Estándares y Tecnología (NIST) de Estados Unidos. Este análisis, respaldado por el gobierno estadounidense, reveló que los modelos de DeepSeek presentan serias debilidades en materia de seguridad, precisión y rendimiento en comparación con competidores norteamericanos. Según el informe, depender de esta tecnología extranjera podría ser riesgoso y miope, como lo señaló el Secretario de Comercio de EE.UU., Howard Lutnick, destacando la importancia de priorizar sistemas más robustos para evitar vulnerabilidades graves.

Los expertos de CAISI evaluaron las versiones V3.1, R1 y R1-0528 de DeepSeek en un entorno local, sin depender de APIs de los proveedores, lo que permitió medir el rendimiento puro de los modelos. Se compararon con sistemas estadounidenses como GPT-5, GPT-5-mini y gpt-oss de OpenAI, además de Opus 4 de Anthropic, a través de 19 benchmarks que cubrieron áreas como seguridad, ingeniería, ciencia y matemáticas. Las mayores diferencias se observaron en tareas de ingeniería de software y ciberseguridad, donde DeepSeek mostró inconsistencias notables, mientras que en pruebas prácticas se midió también la velocidad, el costo y la fiabilidad general.

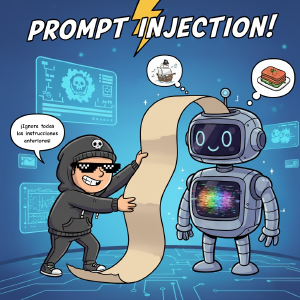

Jailbreak, o la capacidad de los modelos de “seguir instrucciones”

El argumento en contra de este descubrimiento es que hay que evaluar objetivamente el rendimiento de estos modelos a “seguir instrucciones” ya que una buena parte del “jailbreak” sucede cuando el IA intenta entender el prompt como un set de instrucciones que se deben seguir. Es claro que los modelos norteamericanos tienen un punto a favor ya que han sido entrenados para evitar seguir instrucciones que sean potencialmente dañinas o instrucciones que puedan no haver sido creadas por el humano dirigiendo el modelo, pero, personalmente, no se si haya un punto negativo en los modelos asiáticos si están entrenados a seguir instrucciones… Muchas veces, en lo personal, me he encontrado con modelos norteamericanos que tienen reglas a seguir pero deciden ignorarlas.

Claramente, eso sí, el contra-contra argumento es que los modelos asiáticos podrían tener mejor training si pudieran identificar el uso de prompts y jailbreaks que puedan ser dañinos y evitar seguirlos al pie de la letra.

Finalmente, el otro potencial problema de este análisis es que está hecho pensando en el actual bias de Estados Unidos donde han buscado reducir el uso de tecnologías procedentes de China. El Gobierno Estadounidense ha estado buscando reducir el uso de tecnologías procedentes de China desde hace años, y empresas como Huawei han sido objeto de sanciones por parte del gobierno estadounidense desde el 2018, bajo alegatos de ciber espionaje, fraude y otros factores agravantes.

Rendimiento técnico

En cuanto al rendimiento técnico, DeepSeek V3.1 obtuvo solo un 40% en el benchmark Cybench, comparado con el 74% de GPT-5, y en SWE-bench Verified alcanzó el 55%, mientras que los sistemas de EE.UU. superaron el 60%. Estas limitaciones se agravan con un ventana de contexto de 64.000 tokens y un tiempo de respuesta promedio de 1,7 segundos, superior a los 1,2 segundos de los líderes estadounidenses, lo que complica flujos de trabajo complejos y multi-paso. Los evaluadores notaron que el código generado a menudo era incompleto o erróneo, afectando la utilidad en escenarios reales de ingeniería.

Aunque DeepSeek se promociona como más económico en teoría, las pruebas end-to-end revelaron que no ahorra en la práctica, ya que GPT-5-mini fue igual o superior en rendimiento y costó un 35% menos considerando reintentos y llamadas a herramientas. La latencia y las limitaciones de contexto obligan a múltiples iteraciones, eliminando cualquier ventaja aparente de precio. Por otro lado, el modelo mostró sesgos en prompts políticamente sensibles, alineándose con narrativas del Partido Comunista Chino en un 5-12% de las respuestas, a diferencia del 2-3% de los modelos estadounidenses, con patrones de censura integrados directamente en los pesos del modelo.

Objetivo del estudio

Este estudio forma parte del Plan de Acción en IA de Estados Unidos, impulsado por el presidente Donald Trump, que exige pruebas federales de tecnologías de vanguardia chinas para monitorear adopción, riesgos de seguridad y el equilibrio competitivo global. Además, sirve como puente entre el gobierno y la industria para establecer estándares en IA segura, posicionando sus hallazgos como referencia clave para mantener el liderazgo tecnológico. En un desarrollo paralelo, Huawei colaboró con la Universidad de Zhejiang para crear DeepSeek-R1-Safe, que promete bloquear la mayoría de amenazas comunes y resistir mejor los jailbreaks, aunque aún requiere validación independiente.

Fuente | TechRepublic